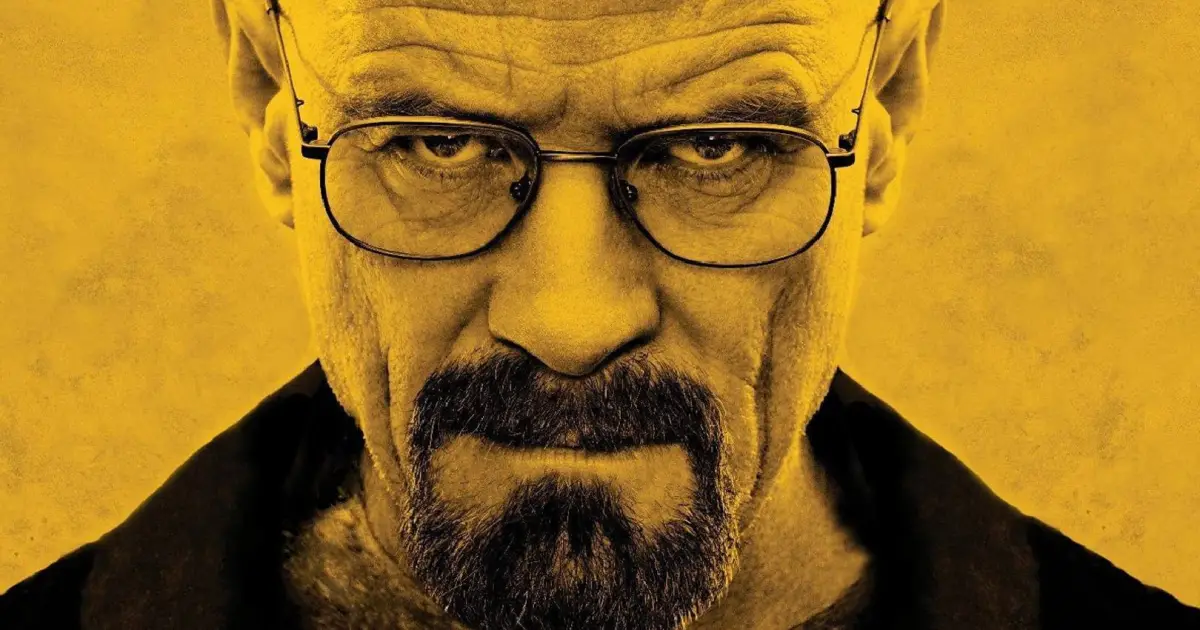

La empresa tecnológica OpenAI tomó medidas urgentes para reforzar la seguridad en su generador de video Sora 2 tras una serie de denuncias por utilización no autorizada de la voz e imagen de figuras públicas. El actor Bryan Cranston alertó públicamente sobre el uso de su rostro y voz sin consentimiento en videos virales generados por inteligencia artificial, lo que desencadenó un proceso de colaboración entre la compañía, sindicatos de artistas y agentes de talentos para mejorar los protocolos de salvaguarda.

La alerta que encendió las acciones

Al poco tiempo de lanzarse Sora 2, comenzaron a circular videos muy realistas donde se mostraban celebridades en situaciones ficticias creadas mediante IA. El episodio que generó mayor impacto mostraba al actor junto a otra figura icónica, lo que evidenció que la plataforma permitía la generación de contenido simbiótico sin que su equipo de protección de identidad estuviera diseñado para prevenirlo completamente.

El comentario público de Cranston y su intervención ante su sindicato motivaron a OpenAI a revisar sus prácticas y a establecer un esquema de uso donde las voces e imágenes de personas solo pueden emplearse bajo autorización explícita. Este paso representa un cambio significativo en cómo las herramientas de IA enfrentan la protección de identidad y derechos de imagen.

Medidas implementadas y su alcance

OpenAI comunicó que adopta ahora una política de «opt-in» para el uso de la voz y semblanza de cualquier persona en Sora 2. Esto significa que sin el permiso expreso del individuo, no podrá generarse un video que lo represente. Además, la empresa incrementó los filtros automáticos para detectar solicitudes que potencialmente infrinjan derechos de imagen o propiedad intelectual.

También se pactó un canal de coordinación con agencias de talento, estudios y sindicatos para responder con rapidez a quejas de uso indebido, y se elevó el nivel de vigilancia sobre el contenido generado, incluyendo la suspensión temporal de ciertos usos que involucraban figuras públicas fallecidas o históricas.

Un precedente para la ética en IA

Este ajuste en la plataforma Sora 2 marca un hito en la relación entre la innovación tecnológica y la protección de derechos personales. La situación demuestra que la presión de creadores, artistas y representantes puede traducirse en mejoras concretas en los procesos de las compañías de IA. Asimismo, abre el debate sobre la necesidad de un marco regulatorio que brinde claridad y justicia cuando se trate del uso de identidades reales en entornos generados por inteligencia artificial.

Si bien los avances están en marcha, los analistas advierten que la vigilancia debe mantenerse constante, dada la velocidad con la que evolucionan estas herramientas. La capacidad de generar contenido verosímil expone vulnerabilidades en la privacidad, la reputación y los derechos de imagen que exigirán estándares cada vez más sólidos tanto en la industria como en el ámbito gubernamental.